- Montpellier

- Dépannage Express

- 06 17 42 78 34

Article de 2017, avec des mise à jour.

Je vais répondre ici aux questions :

Quel sont les meilleurs TV ? En fin d’article.

Est-ce que la 4k HDR, ça vaut le coup ?

La HDR, c’est quoi, ça change quoi ?

Quel puissance CPU et GPU minimum pour lire de la 4K HDR sur PC ?

Peut-on utiliser une TV 4K comme moniteur PC ?

TV 4k HDR Oled, LED, Qled … ou Vidéoprojecteur HDR ?

Est-ce normal si l’image de mon de film 4K HDR est sombre ?

Comment avoir une image moins sombre en HDR ?

Comment déboucher les noirs en HDR ?

Comment avoir un son 5.1 via S/PDIF avec un film 4K Atmos ?

Le son Atmos c’est quoi ?

Pourquoi le film freeze ou saccade ?

Comment configurer mon PC pour lire des vidéo 4K HDR ?

Le dolby Vision est-il indispensable ?

La 4k ça change quoi ?

TruMotion, Motionflow, Auto Motion. La compensation de mouvement, c’est quoi ?

La HDR dans les jeux vidéos, ça donne quoi ?

Et plus encore.

Bienvenue sur Microgitech, spécialiste en réparation informatique sur Montpellier. Dépannage d’ordinateurs portables et de bureau.

Allez, allons-y pour la théorie :

Films 4k, Rec.2020, Dolby Vision, Atmos … c’est quoi ?

Vous songez à passer à la 4k, vous voulez regarder des films 4k HDR, mais vous voulez en savoir plus avant ? Vous êtes au bon endroit.

La cassette VHS PAL est en France le format dominant des années 90.

Dans les années 2000 la VHS fait place au DVD PAL en Europe.

Puis c’est en 2007 que c’est démocratisé le Blu-ray avec sa définition 1080p sois 4.7 fois plus de pixel qu’en PAL.

On arrive enfin en 2016 au Blu-ray UHD, dit 4k à défaut de langage, avec sa définition 2160p sois 4 fois plus que le Blu-ray HD.

——————

Si vous êtes abonné payant à ChatGPT et voulez avoir une conversation avec un expert du dommaine, je vous ai fait un GPTs spécialisé dans la 4K HDR.

Il est en anglais, mais si vous lui parlez en français, il répondra en français.

https://chat.openai.com/g/g-fCoZRRgCH-hdr-expert

Attention, c’est une intelligence artificielle en version bêta, ça fait parfois des erreurs.

Ne lui posez pas de questions sur des événements survenus après avril 2023, ni de conseils sur les marques…

Ça va vous donner des éléments de réponses, mais vous devez toujours vérifier les affirmations des GPTs sur des sites fiables.

Cet article n’a pas été écrit avec une IA.

————————-

Les nouveaux films 4k (UHD) sont en HDR, sauf exception.

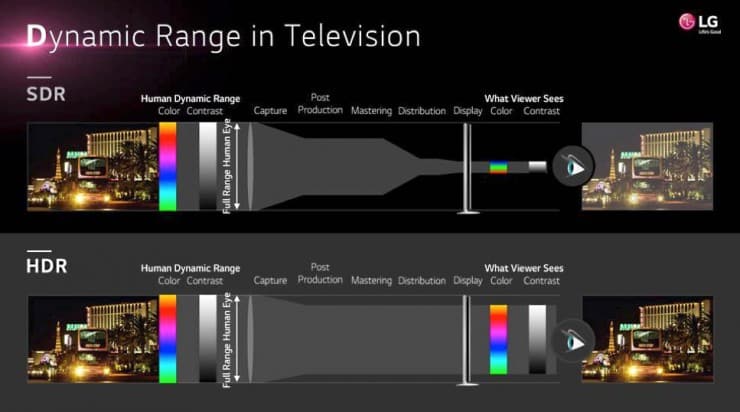

La HDR c’est une plus grande étendu entre la plus faible et la plus forte quantité de lumière qu’une image d’un film puisse afficher pour se rapprocher de la vision humaine naturelle. On passe de 8bits qui permettait 256 nuances par couleurs (RGB) sois 16 millions de couleurs, a 10 bits qui permettent 1 milliard de couleurs. Donc 4 fois plus de nuances par couleurs. On limite ainsi les dégradés en escaliers appelés banding. Le Dolby Vision est en 12 bits.

Pour en savoir plus: http://www.latelierducable.com/tv-televiseur/8-bits-10-bits-cest-quoi-la-profondeur-des-couleurs/

Il est encore courant de trouver des écrans 6 bits sur les pc portables 1er prix.

La perception de la définition d’image est meilleure en HDR, car il y a plus de nuances. Deux pixels côte à côte sont plus distinctifs s’ils n’ont pas la même valeur de luminosité.

La nouveauté qui apporte une amélioration de la qualité de l’image c’est plus la HDR couplée au Rec.2020 (Wide Color Gamut) que la définition 4K.

En SDR (Télévision à gamme dynamique standard) avec donc une télévision HD classique on ne peut pas avoir à la fois des détails dans les zones sombres et dans les zones claires, ce qui fait des noirs bouchés ou des blancs brulés. Faut choisir c’est l’un ou l’autre.

Vous voyez les gros aplats de noir tout moche ?

La High Dynamic Range peut permettre d’augmenter le contraste, la différence de luminosité entre les parties claires et sombres d’une image.

Y a-t-il plus de couleurs dans les films 4k HDR ?

La HDR est couplée au Rec.2020

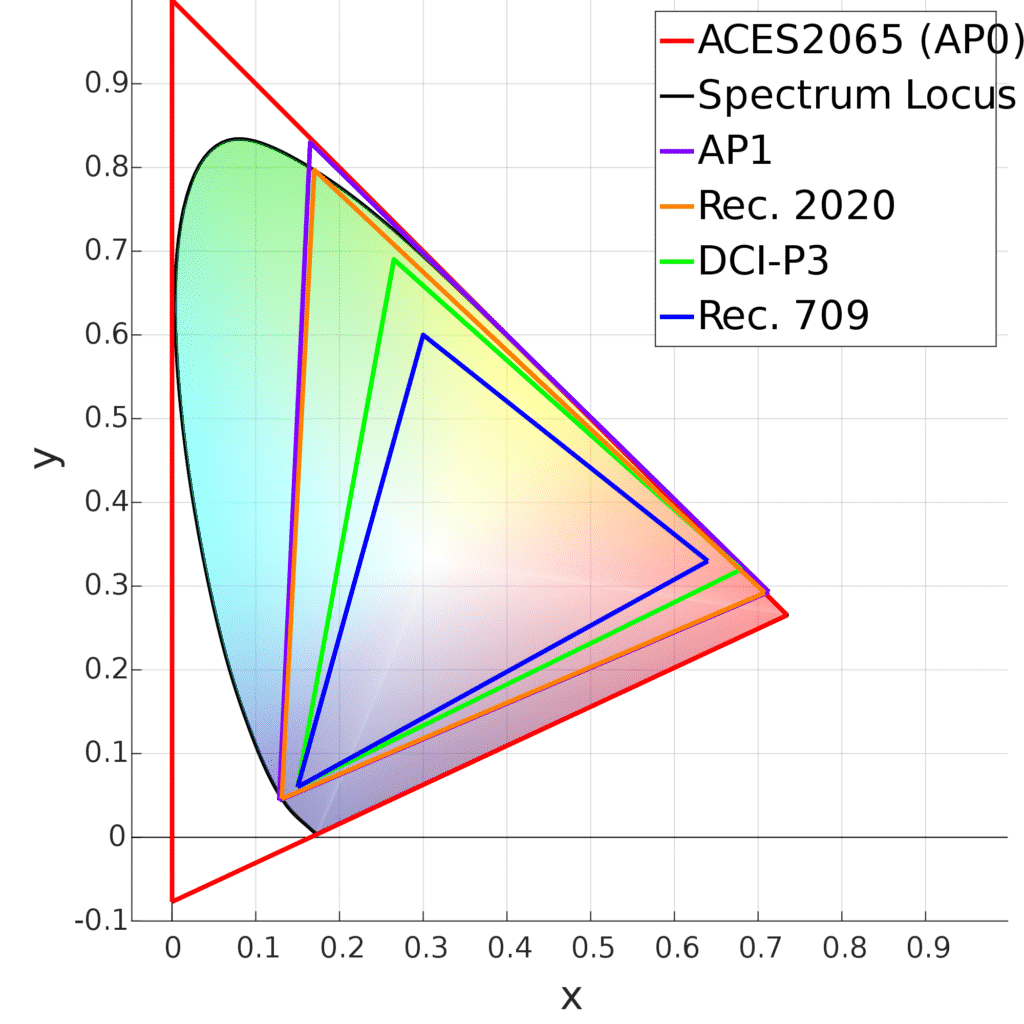

L’espace colorimétrique rec. 601 des TV SD (Les TV d’avant la HD) est quasi le même que le Rec.709 des écrans et TV HD qui couvre environ 35,9% du spectre visible par l’œil humain, alors que l’espace colorimétrique Rec.2020 couvre 75,8% du spectre visible par l’œil humain. Ce n’est pas totalement exploité, une TV UHD (4k) grand publique qui fait 70% du Rec.2020 c’est normal. Ça correspond aux valeurs DCI-P3 sois 45.5% du spectre visible par l’œil humain.

D’après le fabricant Hisense son laser TV présentée au CES 2019, le « TriChroma Laser TV 4K », couvre 100 % de l’espace colorimétrique Rec.2020.

Les films n’exploitent pas forcément la totalité du rec.2020. Ils sont souvent proches du DCI-P3 et ne dépassent pas forcément le Rec.709.

« Spectrum Locus » c’est la vision humaine.

Sur les schémas on pourrait penser que le DCI-p3 ne change pas grand-chose, mais en réalité dans certains films, on voit bien qu’il y a des couleurs qui ne font pas partie du rec.709. Des couleurs qu’on n’a pas l’habitude de voir. Des lasers, des objets magiques …

Il existe des vidéos projecteurs 1080p HDR 10 en rec.709, qui n’apportent, pas plus de couleurs.

Qui dit plus de couleurs et un panel d’intensité plus large, dit meilleurs dégradés et meilleures profondeurs de l’image.

Ça permet d’émettre des piques 10 a 100 fois plus lumineux, qu’en SDR.

Une TV SDR va avoir une luminosité d’environ 120Nits, Une LED Edge pas beaucoup plus, une OLED ou QD-OLED entre 500 et 1500Nits, une Full LED ou Micro-led de 1000 a 4000Nits. çà peut monter à 10 000Nits, c’est en évolution permanente.

En vidéoprojection, c’est différent. Un cinéma SDR va être à 48Nits, un cinéma Dolby (HDR) 100Nits, un Vidéoprojecteur (VP) de maison peut suivant les modèles monter à plus de 200 nits. Bien que le VP soit beaucoup moins puissant que ceux des salles de cinéma, la projection est plus petite et le VP plus proche de la toile.

Mai dit moi Jamy, les Nits, c’est fait pour les pigeons ?

Et non Fred, plus il y en a plus on se rapproche de la vision humaine.

Si le film demande d’envoyer 1200 Nits/m2, mais que l’écran n’est capable que d’en restituer 600, l’écran va sois perdre tous les détails au-dessus de 600 ou plutôt, la luminosité de l’écran va baisser pour ne pas perdre les détailles des hautes lumières, mais il en résulte une image trop sombre.

La majorité des valeurs d’origine sont au-dessus des capacités d’un écran 600Nits, et l’écran fait du tone mapping, il fait correspondre les valeurs d’origine avec des valeurs adaptées à l’écran.

Par exemple la caméra capte les valeurs réelles. 2000 Nits sur le sol, 1200 Nits sur le mur, ils mettent les infos dans le Blu-ray UHD, le lecteur lit les infos et l’envoi à la TV qui ne peut pas l’afficher (sauf certains haut de gamme) donc elle fait du Tone mapping.

Dans les caractéristiques de la TV l’intensité lumineuse est indiquée en Nits ou en candéla, c’est la même chose.

1cd (candéla) = 1Nit. C’est environ l’intensité d’une bougie.

Fut un temps où l’unité de mesure était la bougie, mais elle a été remplacée par la candéla avec l’avènement des lumières directives.

« Candella » ça veut dire chandelle en latin, et bougie ça se dit « candle » en anglais.

D’apres Wikipedia, un Nit c’est la même chose qu’une candéla . Le nit c‘est l’ancien nom donné dans le système MKSA et dont l’utilisation est aujourd’hui déconseillée, car supplanté en 1960 par SI, le système international d’unités.

Sauf qu’en faite non pas tout a fait. ça a remplacé les nits pour les lumiéres directive mais pour les TV, le nit est plus approprier.

Les nits évaluent la luminosité dans toutes les directions.

Les cd/m² mesurent la luminosité dans une direction précise.

Le lumen c’est un flux lumineux à exprimer en « Lux ». La candéla c’est une intensité lumineuse sur une surface exprimée en « cd »

Notez qu’avec les chiffres en anglais un point est une virgule. Une virgule est un espace.

Enfin, passons.

Regardez par la fenêtre, il fait jour, Il fait beau ? Si oui, il y a environ 10 000 candélas d’intensité lumineuse sur une terrasse au soleil.

Un jour, peut-être qu’on ne pourra plus distinguer un paysage à l’écran, d’une fenêtre ouverte sur un paysage.

Tout comme l’image artificielle de certaines grosses productions HD, certains adorent la HDR, d’autres détestent.

La HDR peut être exploitée sans pour autant faire une image artificielle commerciale.

Ça donne plus de possibilités aux réalisateurs.

Ils peuvent faire du commercial, du réalisme ou de l’alternatif. Tout comme pour la HD, mais en plus poussé.

Toutes les photos et vidéos qui vous présentent la HDR Vidéo n’ont pas vraiment de sens sur un écran SDR, on ne peut pas montrer la différence, on peut juste donner une idée.

Concrètement, la HDR en photos, c’est plusieurs photos prises avec des expositions différentes, du plus clair au plus foncé. Certaines auront les détails dans les claires d’autres les détails dans les sombres. Puis on les assemble pour faire une image HDR avec tous les détails.

Avec une caméra c’est un peu le même principe, c’est juste que ça prend plein de photos par secondes.

L’appareil photo de votre smartphone sait faire des photos HDR. Quand vous prenez une photo HDR, il prend plusieurs photos et il en fait une photo HDR, c’est transparent pour l’utilisateur. Maintenant les smartphones peuvent filmer en HDR. Bien sûr, ça ne vaut pas une caméra professionnelle.

Il est possible d’utiliser deux caméras en même temps avec un jeu de miroirs sans tain. Une caméra qui filme avec un réglage pour les basses lumières et une autre avec un réglage pour les hautes lumières. Il faut que ça filme à partir du même point et dans le même temps.

Ça fait longtemps que les caméras films avec des résolutions supérieures à la HD ou à la 4K. La pellicule est bien supérieure à la 4k. C’est pourquoi on peut avoir de vieux films en FULL HD et en 4k. C’est un peu pareil pour la HDR. Les caméras à grande plage dynamique sont arrivés bien avant les écrans avec capacité HDR 10 Bits. On a maintenant des caméras à 32 bits si c’est pas plus. Alors que les écrans sont 10 ou 12 bits.

La pellicule des vieux films est scannée, et l’on récupère des détails et des couleurs que les films HD ne pouvaient pas restituer.

Certaines caméras sont capables de capter toutes les données d’une image HDR en même temps pour éviter les artéfacts.

« À la poursuite de demain » (2015), est la première cinématique d’action diffusée en 4K à large plage dynamique au monde. »

On peut regarder sur IMDB, quelles sont les caméras utilisées dans les films.

Voici une photo HDR pour moniteur SDR, ce n’est pas le screen shot d’une vidéo HDR. Ce n’est pas la même chose.

On voit bien le gain de détails sur le côté du camion et dans les nuages.

Mais dis-moi Jamy, ça doit exploser les yeux, les piques lumineux ? Je n’ai pas envie d’un paparazzi à la maison.

Et oui Fred, c’est fait pour en prendre pleins les yeux.

Ton œil mange de la lumière bien plus puissante du matin au soir et ça ne l’a jamais rendu obèse.

C’est même le seul organe qui ne grossit pas, tout au long de la vie. C’est pour cette raison que les bébés ont des gros yeux. C’est véridique.

Mais pendant que tu te la coules douce devant ton film, l’iris, elle bosse, elle.

Ce n’est pas la pupille qui travaille, car la pupille est un puits de lumière. C’est l’iris, la jolie couleur qui l’entoure qui fait le taf.

Les pics lumineux sont souvent sur une toute petite partie de l’image, ça donne du relief. Un pic lumineux va par exemple être sur le reflet d’une vitre sur 1cm², le reste de l’image ne serra pas très lumineuse et réstera sous les 300cd.

Voici des mesures de luminosités en cd/m² (en Nits) à l’extérieur un jour de ciel gris, avec un peu de soleil. (Sur l’appareil, c’est indiqué en CD, mais il dit Nits)

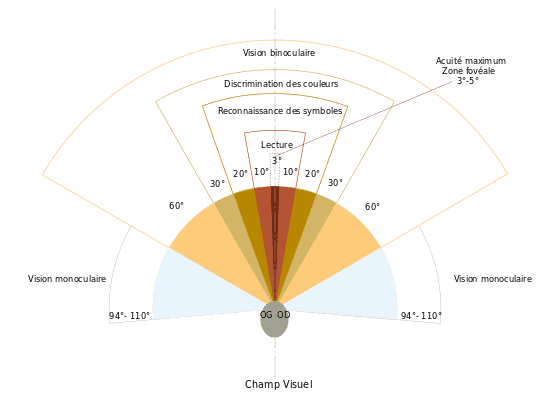

De jour, nos yeux sont capables de voir de 1 à 100 000cd/m2 alors que dans un environnement sombre on va voir environ de 0.01 cd/m² à 1000 cd/m2

Vous pouvez lire mon article sur la lumière bleue.

Pour le visionnage des films

Si le tonne mapping est bien géré, une luminosité faible convient aussi en HDR. C’est juste moins prononcé. La qualité des noirs est importante.

Pour le confort visuel

En soirée, vous pouvez activer le filtre de lumière bleue ou à passer à des teintes plus chaudes. En effet, durant la journée, notre cerveau s’attend naturellement à recevoir de la lumière bleue, car cela correspond à l’ambiance du jour. À l’inverse, dans la nuit, l’exposition à cette lumière peut perturber notre rythme naturel. ( Vous pouvez avoir une fonction automatique IA pour ça aussi )

La taille de l’écran influence la quantité de lumière émise :

Ainsi, un écran de taille moyenne, associé à une pièce bien éclairée, permet de réduire la fatigue oculaire. 65 pouces ça fait TV, 85 pouces cinema mais 75 pouces c’est plus raisonable en usage TV. En géneral, même en luminausité minimum une TV est beaucoup plus lumineuse qu’une toile de cinema.

Les écrans à finition mate entraînent moins de fatigue oculaire que les écrans brillants.

Il faut également considérer la gestion de la luminosité par modulation PWM (Pulse Width Modulation). Cette technique est parfois utilisé pour ajuster la luminosité mais ça provoque des scintillements qui fatiguent les yeux.

Pour préserver votre confort visuel, n’oubliez pas de cligner des yeux régulièrement, de faire des pauses fréquentes, et, si nécessaire, d’utiliser des gouttes ophtalmiques pour prévenir l’assèchement.

l’Ambilight, c’est des leds de couleurs dynamiques autour de l’écran.

Soit c’est fourni avec l’écran, soit on l’achète à part, sois on le fabrique avec un Raspberry pi.

En théorie, ça augmente l’immersion, sensation d’image plus grande, Mais ça ne plait pas à tout le monde. ça fait fête foraine et les couleurs sont fausses ce qui influ sur la qualité de l’image.

Il y a des modelés qui se branchent en HDMI, mais attention de ne pas brider votre HDMI 2.1 avec un HDMI 1.4. Sinon vous pouvez dire au revoir a la 4k HDR …

D’autres fonctionnent avec un capteur que l’on pose devant l’écran. Ils ont l’avantage de fonctionner même si la source ne provient pas de l’HDMI. Mais ils sont moins réactifs, ce qui fait un léger décalage, le mur va s’éclairer de la couleur de l’écran avec un temps de retard. Ce type de modèles réagit aussi si on allume la lumière.

Il y en a aussi qui fonctionnent via USB sur PC ou qui se branchent en USB sur TV Android. Là il n’y a pas les contraintes de l’HDMI, mais il ne faut pas s’attendre à la même qualité que sur un téléviseur Philips Ambilight, c’est souvent du bas de gamme avec des couleurs fluo qui ne correspondent pas.

Il y a beaucoup de réglages et de problèmes.

Si le film a des bandes noires, les leds restent éteintes au-dessus et en dessous de l’écran à moins de changer un réglage pour analyser les couleurs, non pas sur le côté, mais plus proche du le centre de l’écran.

Autre problème, s’il y a la tête d’un acteur sur le côté de l’écran, l’ambilight peut projeter la couleur de peau sur le mur. Ce qui donne un peu la sensation qu’il y a une deuxième tète sur le mur à côté de l’écran. C’est un problème qui n’est peut-être pas présent sur les modèles haut de gamme.

Il y a la solution Hue Play, mais ça ne fait qu’une seule couleur unie, la couleur majoritaire de l’écran. C’est quand même pas mal.

Vous trouverez plus d’info sur ce site: https://ambimod.jimdo.com/2017/06/18/comparatif-des-3-offres-ambilight-%C3%A0-venir-les-plus-attrayantes/

Dans la nature, notre vision est nette là où l’on regarde, le reste est flou, mais constitue l’environnement.

Dans certains casques de réalité virtuelle (PSVR 2), un capteur détecte là où l’on regarde. Puis le casque floute le reste de l’écran, c’est indétectable par l’utilisateur, qui reste totalement plongé dans son environnement. Ça permet de gagner de précieuse ressource GPU.

L’Ambilight c’est un peu le même principe.

Pour un écran SD, un œil parfait ne peut plus distinguer les pixels à partir d’une distance supérieure à :

4,55 mètres pour un 55 pouces (donc sois on met son canapé très loin, sois on voit les pixels)

Pour un écran Full HD, on ne peut plus distinguer les pixels à partir de :

93 cm pour un 27 pouces

1 mètre 90 pour un 55 pouces.

2,25 mètres pour un 65 pouces (Un UHD 4k est utile si le canapé est plus proche, mais le minimum recommandé est de 1M97)

Pour un moniteur Quad HD

70 cm pour un 27 pouces. (Pour du jeu, un Quad HD 120Hz est préférable à un 4k 60Hz)

Pour un écran UHD,

47 cm pour un 27 pouces (La UHD a du sens pour un moniteur de bureau)

95 cm pour un 55 pouces (le minimum recommandé est de 1m67)

1,13 mètre pour un 65 pouces. (Le minimum recommandé est de 1m97)

1M30 pour un 75 pouces. (Le minimum recommandé est de 2m27)

C’est la distance à laquelle on ne voit plus la grille de pixels. On peut tout de même voir un pixel rouge sur un fond blanc.

Au-delà de ces distances, la qualité est peut-être subtilement meilleure en UHD, mais ce n’est pas la définition l’acteur majeur du gain de qualité.

C’est plutôt grâce à la technologie HDR et au reste.

L’association de la HDR et d’une définition plus élevée augmente la finesse des dégradés et la sensation de profondeur dans l’image.

En HD la HDR fait une grosse différence

En 8k sans HDR est beaucoup moins bien que la HD avec HDR. C’est presque comme la HD SDR.

La 8K HDR est mieux que la HD HDR, mais la différence est moins spectaculaire que le passage de la HD a la HD HDR.

La HDR 4000cd est mieux que la 600cd, mais pareil, la différence de profondeur n’est pas très grande. ça permet aussi une plus grande palette de couleurs. Certaines zones sont parfois trop éblouissantes. Du 1000cd c’est bien dans une salle sombre.

Le sport et les reportages ainsi que les concerts en 8k devraient se démocratiser, ça permet notamment le zoom numérique. Pour les films cinémas, il faudra attendre beaucoup plus longtemps.

En HD 1080p, même avec une image projetée de 2 mètres de diagonale à 3 mètres du canapé, on ne peut pas distinguer les pixels.

Au-dessus, faut choisir entre voir les pixels ou passer à une définition 4k.

2 mètres de diagonal à 3 mètres de distance est sous les recommandations d’immersions de THX, SMPTE et DTE.

L’intérêt de là de la 4k ce récent plus si on respecte les dimensions recommandées pour une immersion maximale.

Car pour suivre les recommandations THX, l’image est tellement grande qu’en 1080p on ne peut pas respecter à la fois les recommandations de distance et de taille d’image, on se retrouve forcément en dessous de la distance minimale pour ne pas voir les pixels.

En pratique, si vous dépassez un peu les recommandations, vous ne verrez pas les pixels, j’ai 10 sur 10 aux yeux et je ne les vois pas. C’est plus la qualité de l’encodage qui joue.

Un écran de 100 pouces donc avec une base de 2,21 mètres à une superficie deux fois plus grande qu’un écran 70 pouces et donc des pixels deux fois plus gros.

Sur de telle dimension, le vidéoprojecteur est la seule option raisonnable financièrement.

Même si vous passez à la 4k, vous regarderez encore régulièrement de la HD. Sur une trop grande dimension, les défauts de la source seront plus visibles.

Il se dit que l’immersion en home cinéma devient vraiment prenante à partir de 2 mètres de base.

Avoir une image très grande, c’est moins reposant. Tout le monde n’apprécie pas.

Pour les jeux, la 4k apporte des textures 4k, plus de détails, etc. Il est possible de profiter de plus de détails même si vous êtes en 1080P grâce au downscalle DLDSR de Nvidia. Ce n’est pas aussi efficace que la 4k native, car le downscale peut générer quelques artéfacts et autres, mais c’est supérieur à la 1080p native.

Le poids du film a son importance, moins il est compressé, mieux c’est. Un même film peut être propre avec un poids de 3Go, mais mettre une grosse claque avec un poids de 80Go. Un gros Blu-ray UHD HDR apporte une belle profondeur grâce à la HDR de qualité.

Voici un rapport de France télévision en PDF qui confirme mes propos.

http://idfrancetv.fr/wp-content/uploads/2018/06/A-quoi-sert-la-8K-_.pdf

Le calcul de la distance en fonction du nombre de pixels existe depuis bien plus longtemps que la 4k. Et d’expérience je peux vous dire que la 4k en 8bits sans HDR ça ne change pas grand-chose. À moins d’être collé à l’écran.

Vous pouvez faire vos calculs sur ce site spécialisé dans la distance à laquelle on ne voit plus la grille de pixels. http://jelnet.free.fr/jlnt_scrc.htm

Si vous avez de tres bon yeux (Les moins de 20 ans peuvent avoir 20/10)

Vous avez aussi cet outil pour la distance pour laquelle ça ne plus faire aucune différence. Vous avez aussi cet outil pour la distance pour laquelle ça ne plus faire aucune différence. “À partir d’une certaine densité de pixels, même des lignes d’un pixel de large (noirs sur blanc ou rouge sur vert ou jaunesur violet) deviennent indiscernables d’un aplat gris.”

Les pixels ne sont pas assez large pour les voirs. https://www.cl.cam.ac.uk/research/rainbow/projects/display_calc/Les

« Les résultats démontrent que la limite de résolution est plus élevée qu’on ne le pensait auparavant, atteignant 94 pixels par degré (ppd) pour la vision achromatique fovéale, 89 ppd pour les motifs rouge-vert et 53 ppd pour les motifs jaune-violet… »

https://www.nature.com/articles/s41467-025-64679-2

Et faire le test avec votre écran.

Pour faire simple :

En 16/9, la distance minimale pour une personne qui a des capacités visuelles parfaites est de :

2.9 fois la hauteur pour un écran HD

1.5 fois la hauteur pour un écran 4k ou 8 k.

En deçà de ses distances, on perd en détail, au-delà de ses distances, on perd en champ de vision.

Sans prendre en considération la définition :

Le cinéma recommande un champ de vision de 54° et monte même à 70° en IMAX.

Avec un angle de vision supérieur à 61°, on perd en détail, non pas à cause des pixels, mais à cause de la capacité de nos yeux.

À une distance de 3m, la distance généralement constatée dans les ménages :

Un champ de vision de 54° correspond à un écran plat de 3m de large. Ce qui est supérieur au maximum recommandé de la HD

Le maximum pour ne pas trop perdre en détail est 61° sois environ 3m65 de large. Ce qui est inférieur à la taille maximale pour ne pas voir les pixels avec de l’UHD.

L’IMAX est à 70°, mais l’image IMAX est plus rognable.

Les yeux balaient la scène, pour fournir aux cerveaux une image nette plus grande.

Le champ de vision d’un conducteur se rétrécit avec la vitesse, car ses yeux balayent moins la scène.

L’immersion est tout de même plus grande à bonne distance d’un grand écran qu’à petite distance d’un petit écran, même si le champ de vision couvert est le même.

Il ne faut pas non plus être trop près, mais il est plus économique de se rapprocher a 2,5 mètres que d’acheter plus grand.

« – THX recommande sur un écran 16/9, un angle de vision horizontal de 40 degrés et de ne pas devoir lever ou baisser les yeux de plus de 15 degrés pour regarder le milieu de l’écran. Plus c’est centré, mieux c’est.

– La SMPTE recommande une distance de 3 fois la hauteur de l’écran (2.9 en 1080p).

– DTE recommande une distance de 2 fois la racine carrée de la surface de l’écran. »

Vous pouvez vous faire une idée de la taille de votre futur écran avec une application de réalité augmentée sur smartphone telle que coolblue.

Oui, tu es bien gentil, mais tu ne peux pas nous calculer tous simplement la taille recommandée ?

Il y a un site pour ça.

https://www.distance-taille-ecran.fr/index.php

Faite votre propre calcul:

http://jelnet.free.fr/jlnt_scrc.htm

Ce site se base sur le PPI d’autres se base le PPD.

Un guide:

https://www.son-video.com/guide/a-quelle-distance-doit-on-regarder-la-tv

UFC que choisir a fait un petit test sur 25 personnes. Ils recommandent une distance optimale de 3,7 Mètres pour un 55 pouces 4k, mais 3.2m pour un 55 pouces 1080p. Ça n’a pas de sens. Preuve que la différence est peu ou pas perceptible ?

https://www.quechoisir.org/conseils-televiseur-la-distance-de-vision-n4065/

Vous devez faire un choix entre:

Vous verrez mieux les détails sur un grand écran, même si vous êtes dans la zone 1080p.

Dans le cas d’un vidéoprojecteur, si la projection dépasse par exemple 2M de base, la luminosité est moins forte et donc moins favorable à la HDR.

Un vidéoprojecteur 1080p HDR sur une base de 2M une solution qui pourrait paraitre optimal.

Pour une image plus grande, le prix n’est plus du tout le même, car il faut du 4k natifs et plus de luminosité.

C’est actuellement beaucoup beaucoup plus cher.

Pour ne citer que les plus connus et le plus courant sur nos Blue Ray. Il y a le Dolby digital sorti en 1992, le DTS moins compressé sorti en 1993 et le Atmos sorti en 2012.

Pour ne citer que les plus connus et le plus courant sur nos Blue Ray. Il y a le Dolby digital sorti en 1992, le DTS moins compressé sorti en 1993 et le Atmos sorti en 2012.

Que le son du film soit proche, éloigné, au-dessus (en général par ricochet sur le plafond) ou derrière les spectateurs, avec l’audio Dolby Atmos, la localisation précise des éléments du film à l’image ou hors champs offre une immersion sonore tridimensionnelle particulièrement réaliste.

Ce n’est pas juste avoir du son qui arrive du plafond la nouveauté. La grande nouveauté c’est les objets audios. Le principe c’est d’émuler un objet audio du film pour qu’on l’entende comme si on l’entendait dans la vraie vie, pas comme s’il sortait d’une enceinte. On émule les sons et on peut déplacer chaque objet audio ou bon nous semble dans toutes les dimensions en fonction de notre position et des autres objets. Pour nous plonger totalement dans l’environnement sonore comme si on y était.

On peut gérer le volume et la position de 128 objets en simultané, mais on ne peut pas prendre en compte la réverbération de l’environnement virtuel. Réverbération qui est très présente en situation réelle.

Ça marche même avec juste une barre de son devant nous, mais plus il y a d’enceintes, plus c’est efficace, c’est beaucoup plus efficace avec les enceintes à l’arrière. Un 5.1 non Atmos c’est mieux qu’une barre de son Atmos seule.

La localisation des sons ne doit pas nous faire oublier l’importance de la qualité du son, son timbre, sa couleur, ce qui nous fait vibrer. Les puristes vous diront qu’un son artificiel n’équivaut pas un son naturel. Un objet audio est moins qualitatif qu’un son non retouché.

Tout n’est pas obligatoirement en objets audios, la musique par exemple.

Je vous mets la pub pour être plus claire.

Le DTS:X ( et ses varientes DTS Neural:X et DTS Virtual:X), le Auro-3D et le « 360 réality Audio » Sont des concurents de Dolby Atmos.

Il existe aussi le son binaural, très peu utilisé dans le monde du cinéma, on en trouve par exemple dans des documentaires.

ça reproduit la perception sonore naturelle avec un casque audio.

Les tympans de l’auditeur reçoivent des ondes similaires à celles reçues en situation réelle. Vous comprenez bien que si on est capable de générer les mêmes ondes et la même pression acoustique qui arrive sur les tympans qu’en situation réelle, le cerveau va interpréter les distances et la direction comme pour un son naturel.

Un son atmos dans un jeu vidéo peut être converti par le jeu en son binaural au casque. Un simple casque stéréo suffit. Pas besoin d’avoir un casque gamer 7.1. Si vous avez par exemple un son mono derrière vous côté droit, il va être mixé pour être diffusé d’une certaine manière a l’oreille droite et d’une autre a l’oreille gauche, en prenant en compte les petits échos que vos oreilles et l’environnement auraient produits dans un environnement naturel. De cette manière vous percevez le son comme s’il provenait de derrière vous.

Le comportement du son dans un jeu, peut être calculée de la même manière que le comportement de la lumière, des reflets. Les rebonds des ondes sur les différentes matières. On utilise pour ça les cœurs RT des cartes graphiques modernes.

Dans la nature, nos mouvements de tête nous aident à discerner la provenance d’un son. De nouvelles technologies sont déjà sur le coup.

Allez mettez votre casque et écoutez. ça marche tres bien.

Vous êtes nombreux à être en s/pdif (câble Toslink). Malheureusement, l’Audio Dolby Atmos a un débit top élevé pour passer par l’ optique s/pdif. Via ce dernier l’audio sera donc en stéréo et pourra éventuellement être lu en DOLBY SURROUND PRO LOGIC II. Schématiquement, c’est du 5.1 où la localisation des sons est gérée par la machine et non pas par le réalisateur, ce qui est nettement moins bien. Donc même avec un 5.1, si vous êtes en s/pdif vous serez en stéréo. Et oui, c’est la grosse lose. Mais vous pouvez peut être passé en analogique.

Les données Atmos des Blu-ray UHD sont une extension de TrueHD pour maintenir la compatibilité descendante. Si vous lisez du Atmos, les données d’extension Atmos sont décodées par un récepteur compatible Atmos. Si votre récepteur n’est pas compatible Atmos, les données d’extension sont tout simplement ignorées et la bande sonore est décodée en Dolby TrueHD standard.

Vous devez passer par l’HDMI pour profiter du son Atmos. Attention l’HDMI ARC n’est pas compatible avec l’audio 7.1. Il faut un HDMI eARC ou HDMI pour le son ATMOS et DTS:X.

Notez que les pistes VF, ne sont généralement pas en Atmos donc si c’est en Dolby Digital ou en DTS (non HD) ça passe via le s/pdif.

Vous pouvez convertir l’audio a l’a volé. La config de Kaz propose une conversion AC3.

Pour le commun des mortels, un 5.1 c’est 5 enceintes et un caisson basse. Les gens qui ont un système 5.1 sont équipés de la sorte généralement d’où la confusion. Mais contrairement à ce qu’on pourrait penser, le « .1 » ne désigne pas une enceinte, mais symbolise une fraction de la fréquence. Les basses fréquences en l’occurrence parce que seule la partie basse des fréquences est dirigée sur ce canal.

Même si on y ajoute 2 caissons basses et 6 surround, ça sera toujours du 5.1, car le nombre de canaux reste le même.

Un 7.1 c’est 7 canaux horizontaux et un basse fréquence.

Un 7.1.2 c’est 7 canaux horizontaux, un basse fréquence et deux canaux verticaux. Au plafond.

À ne pas confondre avec un 9.1 et ainsi de suite.

Certaines TV OLED font vibrer la totalité de la dalle sur laquelle est affichée l’image. De ce fait elle fait office d’enceinte.

Pour rappel le son c’est la vibration de l’air et de la matière.

Un hautparleur est constitué d’une membrane qui bouge à l’aide d’un aimant électromagnétique, ce qui fait bouger les molécules de l’air un peu comme une vague dans l’eau. La vibration du hautparleur se répercute de molécules à molécules et arrive au tympan de l’oreille. Ce qui fait vibrer le tympan. La vibration est convertie en signal électrique et est envoyée au cerveau.

Un micro, ça fonctionne un peu comme une oreille.

Un casque à réduction de bruit va enregistrer avec un micro le son qui arrive à lui et emmètre une vibration sonore inverse. Si l’air est compressé, la membrane du hautparleur du casque va être tirée en arrière pour le décompresser pile au moment où la vague sonore arrive à son niveau. La vague sonore est ainsi réduite quand elle arrive au niveau du tympan.

Il y a maintenant des kits son Atmos qui utilisent l’ IA. ça ne fonctionne pas avec des rebonds sur les murs mais avec des micros qui auto calibre le tout. Une bulle sonore avec juste 4 enceintes et un boomer.

Voir la vidéo de PP:

https://youtu.be/secU0zN3f2w

https://youtu.be/LJ25roSUyqA?si=YCEDYlIrqTzPNoGP

La dynamique, c’est la différence entre le son le moins fort et le son le plus fort. Par défaut, les films ont souvent une grande dynamique adaptée aux systèmes son haut de gamme de cinemas. Si vous entendez mal les voix, vous pouvez sur de nombreux systèmes limiter la dynamique via une option. Concretement c’est un limiteur ou un compresseur.

Cliquez pour voir la suite page suivante

C’est normal, les films sont en 24 images par seconde. Pour parer à ce problème, nombreux sont les téléviseurs qui permettent via une option « Motion Flow » ou autre truc motion, d’insérer une ou plusieurs images virtuelles reconstituées, entre chaque image. Ça créer une image virtuelle en se basant sur l’image précédente et l’image qui suis. Ça a ses qualités, mais ce n’est pas exempt de défauts.

Les réalisateurs recommandent souvent de désactiver les options permettant de fluidifier l’image et autres artifices. Elles sont généralement activées par défaut, mais dénaturent l’image et peuvent donner la nausée. Elles ne permettent pas de bénéficier d’une expérience de cinéma fidèle, de retranscrire le travail du réalisateur sur l’image. Mais libre à chacun d’avoir ses préférences. Les moniteurs PC ne sont pas concernés.

Sur PC une RTX3070 n’est pas suffisante pour faire a la fois le tone mapping HDR et la compensation de mouvement. C’est l’un ou l’autre.

Même si le Blu-ray UHD est techniquement capable d’afficher 60 images par seconde, communément appelé le HFR, le High Frame Rate. Ça n’est pas encore démocratisé. À ce jour, le film 4k le Hobbit en 48 images/s présente des défauts similaires au « Motion flow » des téléviseurs. Ça a été vivement critiqué pour ça et aussi parce que les décors paraissaissent moins réalistes. À cause de la qualité d’image qui permet de voir les décors trop en détail.

Au début du 20e siècle les films muets étaient en 12 puis 16 images par secondes, il n’était pas possible de retranscrire correctement l’audio sur la bande avec un tel débit, les sons aigus ont besoin de plus de vitesse. Avec l’arrivée de l’audio, ils sont donc passés à 24 img/s.

Ce qui a bien sûr aussi amélioré la fluidité. Vu le prix élevé de la pellicule, le 24 img/s est devenus la norme.

Et non, on ne voit pas à 24 img/s. C’est la persistance rétinienne qui diminue la sensation de scintillement et c’est l’effet bêta qui donne l’illusion de mouvement.

Voici une liste de film en HFR

https://en.wikipedia.org/wiki/List_of_films_with_high_frame_rates

L’augmentation de la fréquence, autrement dit de l’exposition aux images, améliore la netteté.

La qualité est largement supérieure en 120HZ qu’en 60Hz.

L’augmentation de la définition sans augmenter la fréquence nous affiche des images plus détaillées, mais floues dans les mouvements. Il faut donc augmenter la fréquence et la définition en même temps.

D’après Orange, à distance règlementaire une image full HD à 120Hz est deux fois plus qualitative qu’une image UHD a 60Hz.

La captation et toute la chaine de production doivent se faire à haute fréquence.

Le gain en qualité est si important qu’un décor qui parait réaliste en 60Hz ne fait plus illusion à 120Hz.

Les effets de flou de bougés et de saccades sur les mouvements rapides disparaissent à partir de 250 Hz.

Il faut que l’image soit nette, mais qu’on garde la perception de mouvement, une image trop nette peut casser cette perception.

Plus le temps d’ouverture est faible, plus l’image est nette, mais en contrepartie il y a moins de lumière qui entre, ce qui oblige à avoir un éclairage adapté. Le plateau de Billy Lynn un film en HFR était 5 fois plus éclairé.

Merci à safe, Membre de HCFR pour son rapport très détaillé et technique sur le sujet.

https://www.homecinema-fr.com/forum/vers-l-ultra-hd/synthese-l-ultra-hd-4k-hdr-hfr-blu-ray-hdmi-2-0-etc-t30052759.html

Cliquez pour voir la suite page suivante

Cet autre article du Blog vous donnera les bases.

https://microgitech.fr/des-lunettes-qui-bloquent-la-lumiere-des-ecrans/

Il existe plusieurs tipes de lunettes

Les lunettes à polarisants :

« Chaque œil ne reçoit que l’image qui lui est destinée, grâce à la polarisation de la lumière. La lumière destinée à l’autre œil ne traverse pas le filtre polarisant des lunettes, car son orientation ne la laisse pas passer. » C’est les lunettes qu’on trouve dans les cinemas 3D.

Lunettes à occultations alternées :

« Le projecteur ou le téléviseur émet alternativement à une cadence rapide, l’image destinée à l’œil droit, puis celle destinée à l’œil gauche. Un système électronique installé sur les lunettes et synchronisé avec l’émetteur de l’image rend opaque les lunettes alternativement du côté droit et du côté gauche, de manière que chaque œil reçoive l’image qui lui est destinée. L’alternance des occultations est commandée par un fil ou un récepteur infrarouge. »

Et j’en passe.

De ce fait il est techniquement possible que deux personnes regarde un programme différent sur le même écran. L’écran alterne par exemple une image de Canal + et une image de Arte. Les lunettes nous font voir que les images de Arte ou que les images de canal +. Que se sois un jeux video un Blu-Ray ou une chaine TV qu’importe.

Il est techniquement possible de regarder un film 3D sur écran incompatible avec la 3D. Il faut un PC et des lunettes, mais ce n’est pas l’idéal.

ATTENTION, ATTENTION, ATTENTION, ATTENTION, ATTENTION

_________________________________________________________

Je vous envoie vers mon article dédier:

HDR trop sombre, voici la solution

https://microgitech.fr/films-4k-hdr-trop-sombres-sur-tv-et-video-projecteur-solution-sur-pc/

HDR trop sombre, voici la solution

Source:

https://moovee.tech/le-hdr-pour-les-nuls/

https://forum.kodi.tv/showthread.php?tid=223175&pid=2745194#pid2745194

https://yabb.jriver.com/interact/index.php?topic=126153.0

*2: https://www.youtube.com/watch?v=Lt6IflKAmWg

*1: https://youtu.be/dtvlbVLrvI4

https://www.homecinema-fr.com/tutoriel-hcfr-calibration-sdr-hdr-avec-colorhcfr/13/

https://www.videohelp.com/software/madVR/old-versions

https://www.kazcorporation.com/la-config-kaz

Si le processeur n’est pas assez puissant il faut activer l’accélération matérielle pour que la carte graphique soulage le CPU.

Si le logiciel open source est installé sur une solution matérielle qui décode le DV (Dolby Vision) et qui a donc payé la licence. Le logiciel peu légalement intégré la fonctionnalité pour lire du DV.

Sur le Windows store vous avez le logiciel Dolby Access (payant aprés 1 moi d’essai, 18€) pour lire du Dolby Atmos.

Pour le moment il n’y a pas de lecteur PC compatible Dolby Vision, la GTX 1080 prend en charge Dolby Vision avec des pilotes a jours mais seulement pour les jeux. kodi 19 ou plex prend en charge DV, mais sur Android. il faut une Apple TV ou une Andoid box tel que la shied de Nvidia pour profiter du DV.

Certains jeux PC sont en Dolby Vision.

MPC avec les bons codecs, les bon filtres et bien réglé à toujour donné une meilleur image que VLC, mais VLC est plus simple d’utilisation.

C’est loin d’être nouveau, mais un filtre, c’est la même chose qu’un codec sauf que ça utilise une architecture Windows plus récente. C’est des fichiers d’algorithme qui permette aux lecteurs vidéos de votre PC de lire toutes sortes de formats, certains algorithmes sont plus qualitatifs que d’autres. VLC n’utilise pas les fichiers de filtres et de codecs en question, il utilise ses propres modules. C’est plus simple, mais pas forcement plus qualitatif.

La 4k en HDR10 nécessite un écran HDR pour avoir les bonnes couleurs et l’image plus claire.

Cliquez pour voir la suite page suivante

Pour faire simple, il vous faut au minimum une RTX2070.

—–

Note technique:

Il est fort probable si vous n’avez pas un processeur 7e génération Intel (2017) ou un Rysen d’AMD équipés d’un traitement H265/HEVC 10 bits que votre processeur ne puisse pas traiter la vidéo sans saccades ou freezes. Il faut, donc, régler votre lecteur pour exploiter la puissance de votre carte graphique. Ce qui n’est pas sans nous rappeler les débuts de la HD. Pour lire de la HDR.

Il faut une sortie HDMI 2a.

Les cartes graphiques inférieures à la génération des GTX série 900 (2014) ne sont pas compatibles avec la HDR. Les GTX900 sont compatibles HDR10 statique via HDMI. Les GTX10 série et plus, sont compatibles HDR Dynamique via HDMI et display port 1.4.

Si le film est compressé, il utilise moins de débits.

——

Pour avoir Netflix en 4k sur PC. Il faut le DRM playraidy 3.0 (Dispo à partir des CPU kabi lake (2016) GTX 10 Serie (2017) Ryzen 2eme gen et radeon RX400/500/5000/NAVI (2018).

Les GTX 1660 et les RTX 2000 sont en HDMI2.0b. Pour bénéficier en jeu du HDR G-Sync HD il vous faut un écran compatible et au moins une GTX série 1000 et utiliser de préférence la sortie display port 1.4. . Il faut aussi être sous Windows 10 avec pilotes à jour.

Il est possible d’avoir dû VRR en HDMI 2 avec certains appareils.

Pour le HDMI 2.1. Il faut la génération des RTX 30xx …

Côté AMD, les séries RX 400 et RX 500, la Radeon 7 et les haut de gamme Vega sont compatibles. Prochainement peut-être les Navi aussi.

Les R9 série 300 sont en HDMI 1.4b et DisplayPort 1.2, mais vous pouvez avoir un HDR 8Bits de mauvaise qualité. Limité en 4k à 30 FPS.

C’est quand même une aberration de consommer de 500W pour traiter la vidéo.

——–

Ex: Sur VP 1080p HDR:

Si on remplace la carte graphique par une RTX 3060 (2021):

Le PC ne surchauffe plus et ne sature plus, il consomme beaucoup moins et tout va bien.

Après la tempête, les vacances.

Le GPU n’a plus besoin de faire sous-traiter au CPU une partie de sont travail.

Connecté à un écran HDR FreeSync 2. Les cartes compatibles HDR et FreeSync standards fonctionnent aussi en FreeSync 2 et en HDR.

MadVR est très gourmand en ressource, car il analyse 8 millions de pixels 24 fois par seconde et traite les images à la volée, couleurs, lumineusité, grain …

La HD à ses débuts ça mettait aussi le CPU et les cartes graphiques des grosses config à saturation, ça demandait des connaissances techniques. Maintenant un petit PC de rien du tout peut lire de la HD sans faire de manip particulaire.

Il fut un temps où il fallait un gros PC pour lire de la bouillie de pixel 144p.

(11 et 12e génération plus compatible, car la sécurité de BD UHD repose sur SGX)

Ce n’est pas compatible Dolby Vision.

Une video pour comprendre:

Comprendre le HDCP :

https://youtu.be/gC_a784jlqk?si=hbnlZfE6pfGcDze7

D’apres Mr KEMPF le createur de VLC, c’est avant tout pour que les industriels payent les brevets 4 centimes par HDMI et respectent les régles.

C’est possible de récuperer le flux avec « sensuré »

Une video pour comprendre le chiffrement:

https://youtu.be/_6ukY5p6vTY?si=_UYSEjn-7BKz78PH

Pour la HDR dans les jeux vidéos, il y a la même problématique. Nombreux sont les jeux où la HDR est mal réglée avec pour conséquence, des blancs brulés, des noirs bouchés, des couleurs fluo …)

Ils font donc de la HDR dynamique. Pour ça, il faut que le jeu, le lecteur, donc la console ou le PC et l’écran soient compatibles.

Il y a les jeux en Dolby Vision et les jeux en HGIG. En gros c’est le même principe, proposer de la HDR Dynamique. De la HDR qui s’adapte aux capacités de votre téléviseur.

Est compatible HGIG:

-Windows 10 est supérieur

-PS4 et supérieur

-XBOX One S et supérieur

…

HGIG envoie la calibration « minimum 0.1cd » , « max 600cd ou 1000cd ou 4000cd ou 10 000cd ». Il faut un écran de 600cd minimum pour avoir une HDR dynamique de qualité. Sous cette valeur, la courbe PQ sera faussée.

Sinon, il peut y avoir des réglages manuels dans les options des jeux.

EX : Deathloop PC offre des réglages HDR manuels, mais RDR2 PS4 ne permet pas d’ajuster la HDR manuellement.

(Le noir HGIG est à 0.1cd. Les TV prémium LED sont a 0.05cd, les Oled sont a 0.0005cd. Les VP sur toile grise ont de meilleur noir que les TV LED classiques.)

Voici la liste de jeux compatible HDR.

https://cosmo-games.com/jeux-compatibles-hdr-ps4-pro-xbox-one-pc/

Si votre PC n’est pas assez puissant, vous pouvez changer votre carte graphique ou sinon, une Box 4k sous Android TV vous permettra de visionner des films 4k HDR. Vous avez la Shild. Elle permet en plus de faire du jeu Android exigent ou de streamer des jeux PC.

Vous avez la Shild. Elle permet en plus de faire du jeu Android exigent ou de streamer des jeux PC.

La Shild pro 2019 peut décoder le DV, mais seulement celui des plateformes de streaming et les MP4 simples couche, ça va évoluer, elle est très bien tenue à jour.

Vous pouvez aussi utiliser un Apple TV compatible avec le dolby Vision des plateformes de streaming ou un Zappiti …

Si vous êtes équipé d’une TV, même une milieu de gamme. Cette dernière devrait être équipée d’un lecteur capable de lire les films 4k HDR, via USB s’il ne sont pas trop gros. L’idéal, c’est qu’elle puisse lire le MP4, le MKV et le M2TS.

Attention, chaque appareil à ses avantages et inconvénients assurez vous que lecteur et récepteur sois compatible avec les normes voulut. ex: HDR10+, Dobly Atmos , Dolby Vision

Si vous restez sur PC. Un clavier multimédia peut faire office de télécommande, c’est pratique. C’est le Microsoft All-In-One Media qui tire son épingle du jeu.

Quel câble HDMI pour la 4k ?

L’OR est moins bon conducteur que le cuivre et l’argent, mais il assure un meilleur contact dans le temps, car il s’oxyde moins.

Le plaqué Or est innutile, car sur un cable numerique, les datas ne passent pas, par la partie plaqué Or.

En revanche, plus la longueur du câble est grande et plus on fait passer de débit, plus la qualité du câble est importante.

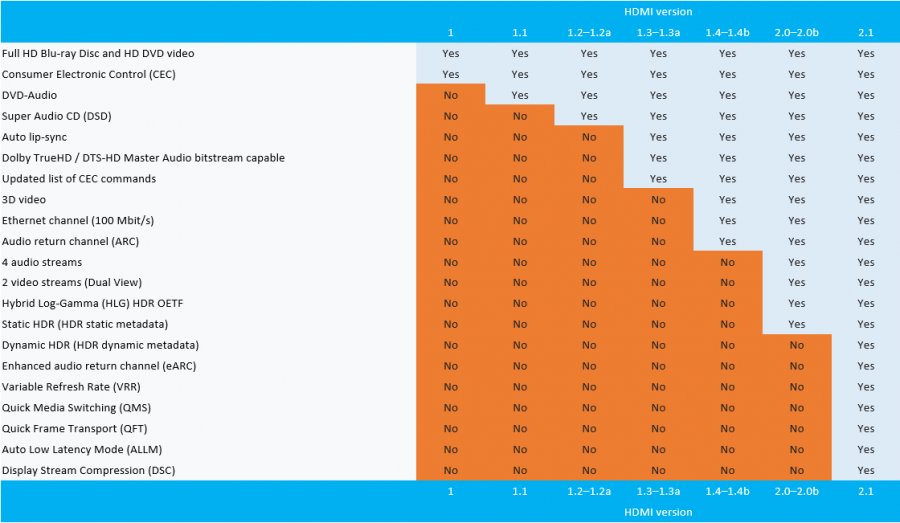

Il y a différentes normes d’HDMI (de 1.0 à 2.1), mais pour faire simple il y a :

Le HDMI standard, adapté a du 720p et au 1080i

Le HDMI High Speed(1.4) pour du 1080p 60 Hz ; 1080p 24hz 3D ; et 2160p 30Hz HDR

Le HDMI Premium High Speed (2), capable de gérer de la 4K 60Hz HDR prévus pour un débit de 18Gb/s

Le HDMI Ultra High Speed (2.1) pour de la HDR 10+ (dynamique) de la 8k et plus. Qui permet tout de même un débit de 48Gb/s.

En réalité se sont les mêmes câblages, c’est la section du cuivre et le blindage qui change, pour éviter les pertes et les interférences et permet ainsi de faire passer plus de débit sur de plus longues distances. Le HDMI 2.1 a un canal en plus, mais ça reste le même câblage.

La norme HDMI 2.0a ou 2.0b sont des normes de périphériques, pas de câble. C’est logiciel, on peut si le constructeur le permet passer d’un « hdmi2 » à un « HDMI2.0a » avec une mise à jour.

HDMI2.0a permet la HDR statique.

La norme HDMI 2.1 permet le plein support de la HDR dynamique et aussi le 120Hz et le VRR.

Le taux de rafraichissement variable « VRR » élimine ou réduit les retards, les saccades et les déchirures de la trame pour un mouvement plus fluide dans les jeux.

Les cartes graphiques GTX de série 1000 et plus prennent en charge VRR, c’est l’équivalent du Freesync de AMD ou du G-sync de Nvidia. Ça permet d’éviter le phénomène de tearing (déchirure en anglais) .

Ça synchronise les FPS

(Frames per second correspond au nombre d’images envoyer par seconde a l’écran )

avec le rafraichissement de l’écran

(le nombre d’affichages des images par secondes exprimées en Hz).

Ce qui évite en jeu d’avoir deux frames (images) en même temps à l’écran au moment où il fait son cycle de rafraichissement. Qui aurait pour conséquence d’avoir affiché à l’écran deux moitiés de frames distinctes, une moitié en bas de l’écran, une moitié en haut décalée dans le temps avec une déchirure au milieu.

Le rafraichissement de l’écran est un balayage de bas en haut de l’écran.

Dès que l’écran reçoit l’image de la carte graphique, l’écran l’affiche, peu importe à quelle ligne de pixels en est le balayage vertical de l’écran.

Voici un exemple où le balayage n’est pas synchronisé avec les fps

Avec les écrans non compatibles, on utilise depuis longtemps une option de synchronisation verticale qui permet d’éviter ce phénomène, mais cette dernière génère de l’input lag , un retard entre ce qu’il se passe réellement dans le jeu et ce que l’écran nous montre. Ce qui fait perdre en fluidité, réactivité et peut être handicapant, notamment dans les FPS de compétition.

( First-person shooter désigne un genre de jeu vidéo, appelé en français jeu de tir à la première personne)

V-sync (la synchronisation verticale) peut générer aussi des micros saccades, car V-sync consiste à attendre que le balayage vertical de l’écran se situe au sommet de l’image entre la dernière ligne et la première ligne de pixels pour afficher une nouvelle image.

Avec le VRR, la carte graphique ordonne à l’écran de se rafraichir en même temps qu’il envoie l’image plus besoin d’attendre. Notez que dans un jeu le nombre d’images par seconde varie en perméance en fonction du temps de calcul nécessaire pour créer l’image. Avec un écran classique, le rafraichissement de l’écran est fixe, par exemple 60Hz. Avec VRR le rafraichissement de l’écran est modulable et se synchronique avec les FPS envoyés par la carte graphique.

Même sans VRR actif et à 60 ips en 120Hz. L’input lag dû à la fréquence est divisé par deux. C’est logique.

La plage VRR de la TV LG C9 est de 40 Hz à 120 Hz.

Le signal numérique HDMI est différent d’un signal analogique. En numérique on dispose souvent d’une vérification d’intégrité du signal et de la correction d’erreurs pour la Data. La correction d’erreurs est intégrée à partir du HDMI 2.1. En réalité par internet on utilise pour le streaming le protocole UDP qui ne permet pas la vérification des erreurs, car on peut tolérer des pertes de données, mais pas du retard. On peut se permettre d’être moins exigeant sur la qualité des câbles numériques qu’avec les câbles analogiques, car en analogique la moindre altération dégradée le signal sinusoïdal avec une influence directe sur l’image. Mais en numérique, on est en binaire. Si le 0 ou le 1 est légèrement dégradé, ce n’est pas grave du moment qu’on reconnait ce que c’est. Le message final reste 100% identique à l’original. Donc malgré l’altération, le signal est lu sans dégradation. Ça passe ou ça casse. Inutile d’avoir du plaqué or. Mais la 4k nécessite plus de débit et donc un câble plus qualitatif.

En passif, il vaut mieux éviter de dépasser les 5 mètres voir les 7.5 mètres. Au-dessus de 15 mètres, il faut réamplifier le signal avec par exemple un câble HDMI actif.

Pour de la 8k full capacité sur un câble cuivre, il ne faut pas dépasser les 3 Metres.

Un câble AWG 24 peut aller jusqu’a 15 mètres en passif alors qu’un câble AWG30 ne dépassera pas les 5 mètres, car la section de ses fils est plus fine.

Oui c’est inversé, plus l’AWG est grand, plus c’est fin. Le numéro correspond aux nombres de passages que la machine a tréfilés à effectuer. Elle est utilisée pour réduire la section d’un fil de métal.

Sur les très grandes distances, on fait passer le signal HDMI sur un câble Ethernet. On peut aussi utiliser des HDMI Fibre Optique.

Il peut y a avoir des exceptions sur le matériel précurseur d’une technologie ou d’une norme, par exemple, les premières TV à être en HDMI2.

Hdmi2 hdcp2.2 bridé en débit 1.4.

ARC pas pris en charge sur câble HDMI….

Pour du jeu ou la HDR, il faut au moins un HDMI 2 Prémiums capables de gérer de la 4k a 60Hz. Les Amazon basic présentes un bon rapport qualité-prix. Mais pour la HDR dynamique, il faut pour bien faire un HDMI 2.1 et un écran HDMI 2.1.

Le HDMI 2.1a permet le SBTM (Source-Based Tone Mapping), plutôt que laisser l’écran gérer tout seul le tonne maping, le travail est partagé avec la source, ce qui permet de réduire la charge de travail pour l’écran peut être aussi la latence. Ça permet d’avoir une meilleure gestion du multiaffichage HDR/SDR. Par exemple si vous avez un écran SDR et un écran HDR sur le même PC ou si vous avez une fenêtre en SDR et une autre fenêtre en HDR.

C’est juste une caractéristique logicielle, une mise à jour de firmware peut faire passer un HDMI 2.1 en 2.1a.

Attention la norme HDMI 2 n’existe plus officiellement, c’est donc du HDMI 2.1, les fonctionnalités du HDMI 2.1 sont optionnels. Pourquoi faire simple ?

La compatibilité de ce câble est:

1080p – 60Hz : YCbCr 4:2:0 OK / YCbCr 4:2:2 OK / YCbCr 4:4:4 OK / RGB OK

1440p – 30Hz : YCbCr 4:2:0 OK / YCbCr 4:2:2 OK / YCbCr 4:4:4 OK / RGB OK

1440p – 60Hz : YCbCr 4:2:0 OK / YCbCr 4:2:2 NOK / YCbCr 4:4:4 NOK / RGB NOK

4K – 30Hz : YCbCr 4:2:0 OK / YCbCr 4:2:2 OK / YCbCr 4:4:4 OK / RGB OK

4K – 60Hz : YCbCr 4:2:0 OK / YCbCr 4:2:2 NOk / YCbCr 4:4:4 NOk / RGB NOk

Il est compatible 4k HDR 60Hz 4:2:0 ou en 4:4:4 en 4k 60Hz SDR.

La 4k HDR 60Hz 4:4:4 nécessite un débit de 17.82 Gb/s c’est un peu juste sur un câble 18Gb/s, il ne faut pas prendre un câble trop grand pour en profiter.

Autrement dit, un jeu Video 4k HDR 10 ou 12 Bits à 60Hz progressifs ne passera pas en 4:4:4, il passera en 4:2:2.

En pratique plus le câble est court, moins l’environnement est pollué en ondes, plus le débit est élevé, et donc plus les capacités du câble sont grandes.

Le HDMI ARC est une prise HDMI qui permet de faire passer du son dans les deux sens. De l’ampli vers la TV et de la TV vers l’ampli. Les autres prises HDMI ne permettent pas de renvoyer le son de la TV vers l’ampli.

Le HDMI CEC permet de contrôler les appareils avec une seule télécommande, par exemple de baisser le volume de l’ampli avec la télécommande de la TV.

Le HDMI HEC n’a pas vraiment décollé, ce n’est pas utilisé, mais il permet de faire passer internet via le HDMI, pas besoin de connecter tous les appareils à la box internet. Si la TV est connectée à la box les appareils comptables branchés à la TV en HDMI le son aussi.

Le flux vidéo 4k d’un film (protégé) doit passer par des appareils compatibles HDCP 2.2, si un appareil n’est pas compatible sur le chemin, ça ne marchera pas correctement, voire pas du tout.

Lecteur, Carte graphique, switch, ampli, écran … tous doit être compatible HDCP 2.2

Les appareils communiquent entre eux, comme vous, vous communiquez avec votre site bancaire.

Avec une connexion chiffrée pour qu’on ne puisse pas intercepter les données, pour qu’on ne puisse pas copier le film.

Mon article de blog « internet » comporte une vidéo qui vous expliquera le fonctionnement du chiffrement et de l’échange de clés.

Cliquez pour voir la suite page suivante

[vc_row][vc_column][vc_column_text]

Nombreux encore sont les films 4k non issus d’un master 4k, mais upscalé d’un master 2k 4:2:2 notamment pour les scènes utilisant des effets spéciaux.

Les signaux de chrominance des Blu-ray HD ou UHD sont encodés en 4:2:0, donc dans une demi-résolution verticale et horizontale. On diminue souvent le nombre d’échantillons, pour réduire le volume d’informations à transmettre et le prix du matériel.

La vision humaine présente une sensibilité moindre à la couleur qu’à la luminosité, on conserve moins d’informations de chrominance que de luminance sans trop dégrader la qualité perçue.

Donc certes, nombreux sont les 4k upscalés de master 2k , mais avec en théorie nettement plus d’information qu’un upscal de Blu-ray full HD. Ce n’est pas la chrominance qui va vraiment changer la donne, mais plutôt le fait qu’à l’origine les détails ont été capturés avec une caméra 4k.

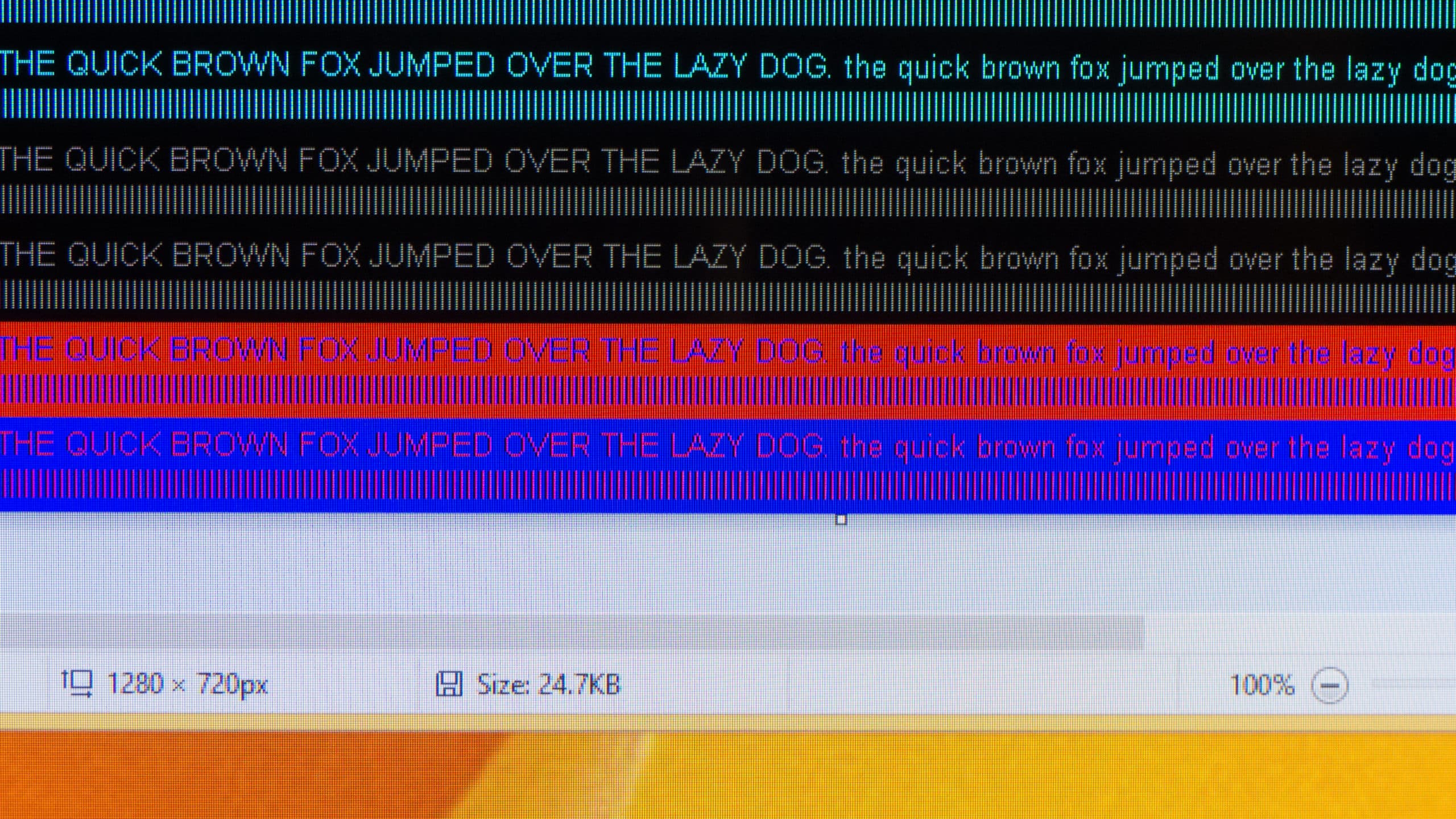

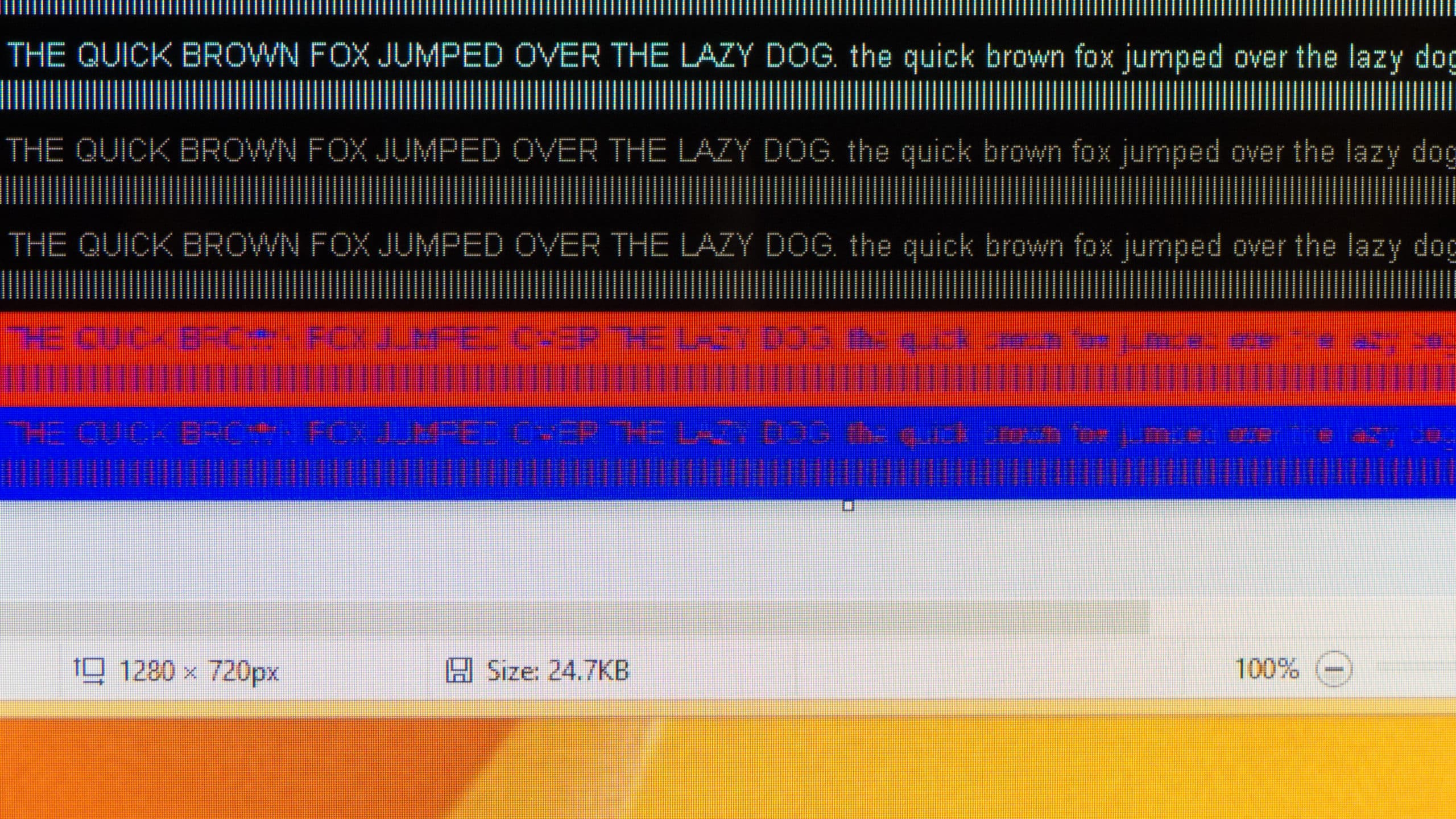

Un moniteur PC dispose d’une chrominance 4:4:4, c’est rarement le cas sur les télévisions : C’est l’une des raisons pour laquelle une télévision n’est généralement pas adaptée pour une utilisation en tant moniteur PC. bien qu’il y a de plus en plus de TV 4k en 4:4:4.

Vous pouvez constater sur le dessin qu’il n’y a plus de vert, car on peut le reconstituer avec les autres valeurs sans que ce soit perceptible par l’œil humain.

Exemple en 4:4:4

Exemple en 4:2:0

Ce site en anglais compare les TV adaptées à une utilisation en tant que moniteur PC.

Ce site en anglais compare les TV adaptées à une utilisation en tant que moniteur PC.

https://www.rtings.com/tv/reviews/best/by-usage/pc-monitor

Il faut un modèle qui présente une bonne réactivité.

La TV peut avoir un mode PC dans les options.

Les TV Oled peuvent marquer, si une image reste fixe trop longtemps, elle ne part plus totalement, ça laisse une image fantôme. Les OLed ne sont pas aussi sensibles que les plasmas, mais en utilisation PC, elles doivent être équipées de systèmes qui limitent le phénomène de marquage par exemple l’option « effacer le bruit ». En théorie ça permet en 1 heure de supprimer un éventuel marquage qui persiste trop longtemps . N’oubliez pas d’éteindre l’écran si vous n’est pas en train de l’utiliser. Mais il ne faut pas le débrancher, car en veille il peut faire des opérations de maintenance pour éviter le phénomène de marquage. De plus la durée de vie des LED bleues d’un Oled est plus faible qu’un LCD. Allumé 10 h par jours ça durée de vie serra plus courte.

Il est recommandé d’avoir les yeux au niveau du haut de l’écran pour ne pas devoir regarder en l’air et garder une bonne position de travail.

Displayfusion, est un logiciel pratique pour du multi moniteur. https://www.displayfusion.com/

Les TV sont moins chères que les moniteurs et on en trouve des beaucoup plus grandes, ça peut permettre aussi de faire double usage, c’est économique.

Il faut prévoir un bureau suffisamment profond pour avoir suffisamment de recul.

Éventuellement, accrocher la TV au mur pour éviter d’avoir un gros pied sur le bureau.

Sinon un grand 21/9 incurvé Quad HD ou 4k est plus approprié, de plus ça fait moins souffrir la carte graphique en jeu, car il y a moins de pixels à gérer en 21/9 qu’en 16/9.

Pourquoi avec une grosse définition de moniteur ?

Parce que vous êtes très proche de l’écran et ça réellement son intérêt. Avec un 38 pouces 21/9 3840 x 1600 pixels, il faut être à 70 cm de la dalle pour ne pas voir les pixels.

Pourquoi un écran PC incurvé ?

Parce que ça permet d’être en face même quand on regarde le côté de l’écran. Sur un grand écran non courbé, avec deux fenêtres côte à côte, ça donne l’illusion que l’écran est courbé dans le mauvais sens.

Pourquoi le mode jeu ?

Les TV ont des circuits de traitement vidéo pour améliorer l’image, mais ça allonge le temps entre le moment où la carte graphique envoie une image et le moment ou l’écran affiche l’image. Le mode jeu, permet de ne pas faire passer l’image par les circuits de traitement pour diminuer l’Input lag.

Si vous voulez utiliser une TV 4k comme moniteur PC. Notez qu’une 55 pouces 4k a un pitch similaire a un 27 pouces 1080p alors qu’ une 65 pouces 4k a un pitch similaire a un 22 pouces 720p. ça à la même densité de pixels.

La chrominance et la retouche en détail

Cliquez pour voir la suite page suivante

Il ne faut pas confondre définition et résolution :

La définition (display resolution) c’est le nombre de pixels.

La 4k c’est 4096×2160 = pixels à l’ horizontale fois pixels à la verticale = 8 847 360 pixels à l’écran.

C’est avec ce simple calcul que j’ai calculé la relation entre chaque définition.

La résolution (pixel density), c’est le nombre de pixels de la dalle (de l’écran) divisée par la surface de la dalle.

Exprimé en points par pouce ppp ou ppi en anglais. ( Pour une image numérique, c’est presque pareil, PPP ou DPI en anglais)

Le pitch c’est la distance entre deux pixels. Pixels constitués d’un groupe de trois luminophores. Un rouge, un vert et un bleu.

Il indique la densité de pixels. Plus il est petit, meilleur est la finesse de l’image.

A même définition plus l’écran est grand plus le pitch est grand.

Il existe des écrans ou la distance entre les pixels est particulièrement petite sans pour autant avoir plus de pixels.

Par exemple Samsung exploite un écran pour son casque de réalité virtuelle Samsung HMD Odyssey (non Commercialisé en France pour le moment) ou les pixels sont très rapprochés pour éviter l’effet de grille. Mais il n’y a pas plus de pixels. Ça ne nécessite pas plus de puissance GPU.

Un écran 36 pouces Quad HD a un pitch similaire à un écran 27 pouces Full HD, mais l’image sur le 36 pouces est composée de plus de pixels. Plus on s’éloigne de l’écran, moins on voit les pixels.

L’augmentation de la définition de votre écran permet d’avoir un écran plus grand et/ou de se rapprocher de son écran sans pour autant voir les pixels et donc ne pas perdre en qualité d’image.

À même distance plus l’image est grande, plus on distingue ses détails, la perception de qualité est donc plus grande.

Lire de la 4k sur moniteur Quad HD ou HD 21/9 ?

Si vous avez un écran avec une définition supérieure à la HD, vous pouvez tester la 4k.

Un écran HD 21/9 est dit HD, car sa définition verticale est de 1080 pixels. Mais sa définition horizontale est équivalente à celle des écrans Quad HD. Si bandes noires il y a, vous tronquez les bandes noires qui encadrent le film et profitez d’une définition Quad HD sois pour rappel 1.8 fois plus détaillé que la HD 1080.

Si vous êtes sur un moniteur Quad HD 40 pouces, 1 mètre de distance suffit pour ne plus voir les pixels et donc avoir la même finesse que s’il s’agissait d’un 4k.

Vous pouvez comparer les tailles et formats de dalles d’écrans sur ce site.

http://www.displaywars.com/36-inch-16×9-vs-34-inch-21×9

Il ne faut pas confondre la Quad HD avec la 4k ou avec la 2k, c’est une erreur très courante.

L’ UHD (4k) c’est 4 fois plus de pixels que la HD 1080p .

La Quad HD (QHD) c’est 4 fois la HD 720p (HD ready) et 1.8 fois la HD 1080p (Full HD). qHD c’est 960×540 rien a voir avec la QHD 2560×1440.

QHD c’était aussi le non commercial donné à la 4k pour 4 fois 1080p, mais depuis 2013 ça ne l’ai plus.

La HD 1080p c’est 2,25 fois la HD 720p.

La 2K ce n’est pas la moitié de la 4k c’est le quart de la 4k.

4K et UHD (Ultra HD) ce n’est pas exactement la même chose.

La définition 2k est légèrement supérieure à la définition Full HD 1080p. C’est le format cinéma.

La 4k (DCI) est légèrement supérieure au 4K (UHD). Pareil, c’est le format cinéma.

La 8k est légèrement supérieure à l’UHD2, c’est 4 fois la 4k.

Calibrer l’écran avec une sonde est recommandé, mais pas forcement utile. Le résultat est souvent bluffant sur moniteur. De plus par défaut, un écran non calibré émet en général plus de lumière bleue nocive que nécessaire. Microgitech dispose de matériel de calibrations professionnel. N’hésitez pas à faire appel à nous, si vous êtes sur Montpellier.

Une erreur courante que je rencontre souvent, c’est les clients qui mettent le réglage de contraste à fond, la netteté à fond…. C’est une mise au point, ce n’est pas parce que c’est à fond que c’est plus net, au contraire, ça fait un dédoublement. Le contraste à fond, fait perdre des détails dans les hautes lumières.

Dans les faits de nos jours, les TV sont souvent bien calibrées d’origine pour les couleurs.

Il faut généralement utiliser le mode cinéma.

pour en savoir plus voir:

https://www.son-video.com/guide/comment-bien-regler-l-image-de-son-televiseur

Quel Blu-ray UHD privilégier pour en prendre plein la vue ?

Il y a de nombreux faux Blu-ray UHD qui sont en réalité un upscal d’un 2k. Mais pas de quoi en faire un fromage, à moins d’être à trop courte distance de l’écran.

Voici une liste de faux https://www.senscritique.com/liste/Blu_Ray_Ultra_HD_Les_faux/1243771

Il y a de vieux films en 4k, mais ils ont été tournés avec de la pellicule donc c’est possible.

Vous pouvez trouver des sites qui testent la qualité vidéo et audio des films, ça vous donnera une idée du ressenti en pratique par des passionnés, très pointilleux sur du matos haut de gamme. Tout le monde n’a pas la même sensibilité.

Par exemple:

https://www.hdnumerique.com/tests/4k

ou

http://www.cinema-du-loup.com/collections-c22824999

La 4k ne change pas grand-chose, mais la HDR si elle est bien réglée, va vous mettre une claque. Les couleurs et la profondeur … C’est presque de la 3D.

Restpectez l’angle de vision de 40°, ne prenez pas du bas de gamme et calibrer votre écran.

Il n’y a parfois pas beaucoup de différences, parfois de grosses différences même sur les vieux films.

Voir les vidéos LE LABO DE JAY

https://www.youtube.com/channel/UCyzCqHyxr0uIF3eVFc9KPEQ/playlists

La version HDR des tests sur YouTube est convertie en SDR tout en gardant le plus de détails possible, mais ce n’est pas véritablement représentatif du rendu réel. Si votre écran est HDR, vous pouvez télécharger la version HDR des tests sur son site. Le lien est sous ses vidéos.

C’est quoi le codec H265 des Films 4k HDR ?

Le Blu-ray UHD c’est aussi la venue du H.265. Un nouveau format, un programme de compression/décompression.

Pour citer les plus courants

Le DVD était en MPEG2

Le Divx généralement en MPEG4 part 2 dans un contener .avi

Le Blu-ray en AVC/H.264

Les HD 1080 sont des x264 dans un contener en .mkv ou dans un conteneur .mp4

Le Xvid, X264, X265 sont des équivalences libres de droits.

À même qualité, le HEVC/H.265 prend deux fois moins de place que le AVC/H.264, mais le decodage du H.265 nécessite 2 a 3 fois plus puissance . Et donc un PC nettement plus performant.

Chaque nouveau format apporte son lot d’avantages qui améliore surtout son taux de compression. Qui dit meilleure compression dit meilleure qualité a poids identique.

Le AV1 est un codec libre particulièrement adapté au streaming. Il est compatible DV et il est environ 30% a 40% plus efficace que le VP9 et le HEVC H.265.

AV1 Intègre déjà des outils perceptuels :

Activity masking : adapte la compression selon la complexité locale (plus flou = plus compressé).

Psychovisual optimizations : module la quantification selon la sensibilité humaine aux contrastes.

LE H. 266 dispose de mécanismes perceptually weighted quantization (PWQ), qui réduisent le débit dans les zones moins sensibles. C’est jusqu’à 40 % de gain par rapport à x265.

Notez que ce n’est pas parce qu’un fichier est encodé avec un codec plus efficace qu’il est mieux encodé. Quel que dois le codec le résultat peut être mauvais.

Certains encodeurs expérimentaux utilisent des modèles IA pour détecter les zones d’intérêt (visages, texte, objets) et moduler dynamiquement le bitrate local.

Les conteneurs : Contrairement au .mp4, les .mkv sont capables de contenir plusieurs pistes audios et vidéos en revanche les .mp4 sont plus léger et compatible avec d’autres lecteurs. Le .m2ts permet contrairement au .mkv de ne pas toucher aux fichiers d’origines, il n’y a pas d’encodage et donc zéro perte. Le MP4 et le m2ts peuvent contenir du Dolby Vision, et maintenant sur du MKV aussi.

Ce n’est pas parce que vous téléchargez un film sur une plateforme légal que vous bénéficiez de la qualité originale du film, en dématérialisé, les films 4k HDR sont souvent fortement compressés. Ce procurer le Film en galette Blu-ray UHD est la garantie d’avoir la qualité originale. Plus d’info sur mon article :

https://microgitech.fr/regarder-videos-internet/

Avoir une grande image est très appréciable, ça met une bonne claque. Pour ça, seul le videoproj permet d’avoir une image de 2 mètres de large ou plus a prix raisonnable.

Si votre vidéoprojecteur n’a pas de prise antenne et qu’il n’est pas relié à une box TV vous n’avez pas de redevance TV à payer. C’est 138€ d’économie par an. À terme, ça revient beaucoup moins cher. Édit il n’y a plus de redevance depuis 2022.

La HDR est aussi un gros plus sur VP, mais les TV restituent mieux la HDR. Sans compter qu’un videoproj c’est aussi beaucoup de contraintes. Placements, bruits, réactivité, luminosité de la pièce, contenu HDR trop sombre si on ne passe pas par mad VR… Il faut utiliser une carte d’acquisition sur le PC pour gérer le 4k HDR des périphériques externes avec madvr. ou acheter un Madvr Envy, mais ça coute entre 9000€ et 15 000€ suivant modéle. Une carte d’acquisition coute 150€, mais il faut un gros PC et c’est plus difficile à configurer et la protection DHCP si elle est présente, empêche la capture et donc le traitement par mad VR. voir ici:

https://www.avsforum.com/threads/videoprocessor.3206050/

Il y a des VP qui intègrent une gestion dynamique des métadonnées ou qui permettent de calibrer les pics lumineux.

Les TV de plus de 85 pouces sont de moins en moins chères, si vous avez le budget c’est encore mieux pour la HDR et le Jeu vidéos. Pour rappel, il faut respecter l’angle de vision de 40°.

À 3 mètres de distance, même une TV Samsung 75Q950R 75 pouce 8k hdr 4000cd a 5000€ ne vaut pas l’immersion d’un Vidéoprojecteur XIAOMI Mijia ALPD3.0 laser, focale classique à 900€, 1080p HDR sur toile Bessel a 70€ avec une image de 2 mètres. Le choix est subjectif.

Même en Dolby Vision, les ombres sur les visages sont légèrement trop prononcées à mon gout. C’est ce qui donne du volume.

Attention, si vous projetez sur une base de 3 mètres, vous perdez en luminosité en en qualité de la HDR.

Attention, le bruit du vidéoprojecteur est souvent une grosse contrainte. Il est mesuré en dB, voici une idée de l’échelle.

| Indication de niveau | Rapport à la valeur nominale | Impression sonore |

|---|---|---|

| +16 dB | × 6,4 | |

| +10 dB | × 3,2 | deux fois plus fort (voir Sone) |

| +6 dB | × 2 | |

| +3 dB | × 1,4 | |

| +2 dB | × 1,25 | |

| +1 dB | × 1,12 | augmentation tout juste perceptible |

| 0 dB | × 1 | Tension ou pression acoustique nominale |

| −3 dB | ÷ 1,4 | |

| −6 dB | ÷ 2 | |

| −12 dB | ÷ 4 | |

| −14 dB | ÷ 5 | |

| −20 dB | ÷ 10 | quatre fois moins fort |

| −40 dB | ÷ 100 | seize fois moins fort |

| −60 dB | ÷ 1000 | à peine audible en général |

Plus l’image est grande, plus on voit les détailles, mais aussi les éventuels défauts de la source sont plus visibles. Vous ne regardez peut-être pas que des Blu-ray UHD. Les VP ne sont pas l’idéal pour le jeu. Mauvaise réactivité, bave en déplacements. Il existe des VP spécial gamer.

Regardez les tests avant achat. Notez que les tests sont souvent très exigeants. Vos exigences ne sont peut-être pas d’atteindre la perfection.

Par exemple sur:

http://www.passionhomecinema.fr/blog/

https://homecinema-tendances.eu/cat/tests/

https://www.lesnumeriques.com/videoprojecteur.html

Le Xiaomi Mijia ALPD3.0 est un bon proj 1080p HDR très silencieux. C’est un mono DLP.

https://www.passionhomecinema.fr/blog/index.php/20/01/2020/test-xiaomi-mijia-alpd3-0-lavis-de-gregory/

Attention à l’effet arc-en-ciel (AEC) si vous êtes sensible. Plus le contraste est bon, plus l’effet est prononcé. Le contraste est bon sur ce proj. 1 à 2 personnes sur 10 sont sensibles aux AEC. Environ 1 personne sur 10 ne s’habitue pas. ça reste de petits sondages et je ne serais pas étonné qu’ils soient sous-estimés.

Les sous-titres sont la source principale des AEC, car blanc sur noir c’est très contrasté.

Pour limiter les EAC, il suffit de mettre un peu de transparence aux sous-titres pour baisser leur contraste ou de changer leur couleur.

Si vous êtes sensible aux AEC, vous pouvez prendre un tri LCD. Epson fait de bons modèles.

…

Il existe des vidéos projecteurs 4k HDR pour les petits budgets.

Ce n’est pas ou quasi pas perceptible pour l’utilisateur, mais si ces videoproj sont jusqu’à 4 fois moins chers, c’est parce qu’ils utilisent un tour de passepasse. Ils découpent la source 4k et la diffusent en 4 images 1080 côte à côte.

Malheureusement pour le moment c’est au détriment du contraste, il vaut mieux un bon 1080p qu’un mauvais 4k.

Pour 500€ on trouve des 1080p qui proposent une belle image. Les 4k capables de restituer une image HDR correcte sont plutôt à partir de 1000€. Les 720p ont une définition trop faible pour ne pas percevoir les pixels.

Avec un vidéoproj, mêmes lumières éteintes, il faut supprimer les pollutions lumineuses, mur blanc, plafond blanc … ou utiliser une toile technique.

Voici un exemple dans une salle avec pollution lumineuse par les murs et le plafond.

Derrière la toile blanche qui se lève, il y a une toile technique. On voit bien l’amélioration des noirs.

Mais si la pollution lumineuse a été supprimée par exemple avec un tunnel de rideaux noirs, il est préférable de ne pas utiliser de toile technique. En plus c’est beaucoup moins cher.

Exemple: http://www.cinetson.org/phpBB3/viewtopic.php?f=2&t=39578

Agrafer un grand drap noir au plafond, ça change déjà la donne.

Contrairement aux idées reçues, pour visionner des films SDR dans votre salon la nuit, avoir un vidéoprojecteur très lumineux n’est pas forcément un bon point. Pour avoir de beaux noirs, la norme SMPTE préconise 48 cd/m², c’est vraiment pas beaucoup.

En SDR (en HD classique) on recommande environ 16fl. En HDR on recommande 26fl. C’est même pas le double. En télévision l’augmentation recommandée est au moins 10 fois plus grande.

Hervé Thiollier explique ça mieux que moi:

https://homecinema-tendances.eu/des-projecteurs-de-plus-en-plus-lumineux-est-ce-profitable-ou-problematique/

Un PDF

http://makingvideo.free.fr/pdf/lux-lumen-….pdf

Un exel pour calculer les candélas (la distance ???)

https://www.homecinema-fr.com/forum/ressources/file/171273

Mais ce n’est pas parce qu’un proj fait 800 lumens que la qualité est bonne.

Plus de luminosité est utile, pour de grandes bases et/ou pour diffuser en journées. Pour la HDR c’est différent, il faut que ça envois.

Les vidéos projecteurs laser ultras courte focal sont de plus en plus accessibles et présente de nombreux avantages.

On les pose sur le meuble TV et ils projettent une très grande image.

Grâce au laser, il n’y a plus besoin de changer les ampoules.

Un laser TV est un videoproj ultra courte focal très lumineux avec une toile technique pour contrer la pollution lumineuse.

Les toiles techniques (ALR) spéciales ultracourtes focales (UST) sont très chères. Les ALR classiques bloquent la lumière qui ne vient pas d’en face. Les ALR UST bloquent la lumière qui ne vient pas d’en bas.

Voici des fabricants de toile à contacter par email.

http://www.xy-screen.com/xy_en/fabric/fabric.asp?id=1

https://www.elitescreens.eu/fr/

http://www.vividstormscreens.com/

https://www.carlofet.com/shop/compare-gray-screens# (Réputé pour son rapport qualité prix orienté prix)

https://www.lumene-screens.com/ecrans

http://screendesigner.da-lite.com/Default.aspx

On trouve des toiles pas chères sur https://www.alibaba.com/showroom/telon-projector-screen.html

Il est possible de faire des commandes groupé par exemple sur le forum www.homecinema-fr.com pour avoir 10 % ou 30% … de réduction.

Meme si c’est pas prevu pour, il est possible d’utiliser une toile de fond réversible pour photographie (Bessel) coté gris.

Beaucoup de gens apprécient l’image sur toile grise, pour la profondeur des noirs. Mais l’image en éclats, les couleurs sont ternies, il faut booster les valeurs dans les paramètres de limage pour avoir un résultat convaincant. L’idéal c’est sur toile blanche dans une salle dédier feutré de noir. Ou à défaut une toile ALR dans un salon, mais c’est très cher. Ce n’est pas le même budget, une toile ALR est un investissement sur le long terme qui permet d’avoir à la fois de beaux noirs et de garder l’éclat de l’image. Attention il y a beaucoup de critaires a réspecter, angles de projection, distances de projection …

Si le Throw ratio de votre toile est 1.5 mais que votre VP a un ratio de projection fixe de 1.2, vous ne pourrez pas utiliser le VP en question avec cette toile, car le VP serait trop proche de la toile pour ne pas avoir d’alo lumineux au centre de la toile. Si on éloigne le proj pour respecter la distance minimale de projection, l’image projetée serait plus grande que la toile.

Même sur toile blanc mat gain 1 basique, il y a différentes qualités. Il y a pleins de défauts possibles par exemple, la lumière qui se diffuse dans les fibres ce qui créer un effet de blooming et fait perdre en contraste.

Voici une comparaison entre le Vividstorms 0.8 ALR VS bessel coté gris réalisé par rluxx sur le forum homecinemas-fr. On constate que la toile bessel plus sombre fait perdre beaucoup en éclat. Ça se rattrape en partie en augmentant le réglage de la saturation, du contraste et en corrigeant les couleurs.

Si vous avez un gros PC gamer, la toile bessel couplé a un VP 1080p HDR présente un très bon rapport qualité prix pour une projection dans le noir. Il faut un vidéoprojecteur lumineux et calibrer l’image.

(Ne vous trompez pas, nombreux sont les VP ou il faut faire les réglages sur l’entré HDMI pas sur l’écran d’accueil sinon vous jouer sur les réglages de l’accueil seulement)

Pour la HDR, il faut en priorité faire le tone mapping de la HDR en temps réel avec une bonne carte graphique et pour bien faire une toile a gain. Il faut aussi projecter sur une surface pas trop grande. Par exemple une bonne toile ALR avec un gain de 1.5 si vous avez les moyens. Même sur toile bessel avec le dérnier MadVR le résultat est spectaculaire bien qu’un peu sombre. L’image est reposante avec une belle profondeur. Le rapport qualité prix est imbatable.

Edit: 2023. Il faut tout de même comparer avec les grandes TV 85 pouces, le prix baisse rapidement et maintenant il n’y a plus de redevance TV.

A l’avenir, il faudra comparer avec les casque VR tres hautes résolution (Environ 5k par oeils) pour pouvoir voir des film 4k sur écran virtuel OLED de 30 Metres. Le reste de la résolution est pour le champ de vision réstant autour de l’image du film 4k. Avec eyes tracking pour faire tourner les jeux.

Un outil pratique pour faire des calculs: http://webprojectorcalculator.com/ (lien mort ?)

Une comparaison de technologie de toiles:

À la base le vidéoprojecteur offre un contraste ANSI élevé.